Interviews zu NVIDIA's Cg Sprache

The Register haben ein Interview mit Andrew Richards, dem Gründer von Codeplay, welcher sich eher kritisch zu NVIDIA's Cg äußert. Positiver sieht dies allerdings NVIDIA's David Kirk.

ATi und NVIDIA gemeinsam auf der GDC Europe

Auf der GDC Europe werden ATi und NVIDIA gemeinsam über die Verwendung der DirectX 9 Shader sprechen. Vielleicht hat man auf diesem Sektor wirklich sinnvoll zusammengearbeitet...

3D-Mark 2001 SE Update

MadOnion haben ein Patch veröffentlich, was Probleme mit DirectX 9 und neuen Grafikkarten behebt.

- MS DirectX 9.0 support

- AGP 3.0 (AGP 8x) support

- Support for the latest hardware (such as SiS Xabre)

- Support for graphics cards with pixel shader support but no vertex shader support

- All other identified issues have been fixed

NVIDIA's Cg veröffentlicht

NVIDIA hat ihr Cg Toolkit veröffentlicht. Dabei handelt es sich um eine Shader Sprache, welche Pixel und Vertex Shader Code für OpenGL (natürlich nur NVIDIA Extensionen) und DirectX 8 / 9 erzeugt. Der DirectX 8 / 9 Code läuft auf jeder Karten welche die Pixel Shader bietet, der OpenGL Code nur auf NVIDIA Karten. Somit ist Cg keine Konkurrenz für OpenGL 2.0, sondern lediglich ein Aufsatz, elche die Entwicklung von Shader Code beschleunigt.

SiS Xabre 400 Review

Ein vollständiges Xabre 400 Review haben Digit-Life online. Die Darstellungsqualität der Xabre liegt jedoch unter den Niveau einer GeForce 3/4.

Neues Treiberpacket von ATi

ATi nennet ihr neues Treiberpacket "CATALYST" - hinter einem neuen Treibermenü, mit mehr Einstellungsmöglichkeiten, verbergen sich ATi's unified Grafiktreiber, das Multimedia Center, Hydravision und für die AIW Karten die Remote Wonder Software. Zusätzlich gibt es ein Diagnoseprogramm namens Smartgart. Die Treiber gibts hier.

Matrox Parhelia 512 Benchmarks

Hier gibt es ein Benchmarks mit einer beta Parhelia 512 Karte.

NVIDIA's Cg Sprache

Was lange Zeit als "GLIDE" für NVIDIA's NV30 durch das Internet geisterte ist durch eine Fehler von IGN nun frühzeitig raus. Cg ist eine höhere Programmiersprache zur Programmierung der Grafikkarte.

Nvidia Cg Revealed

The graphics maker announces big news in the world of software.

June 10, 2002 - Color me surprised. NVIDIA's next announcement isn't for their next piece of high-tech hardware; instead the company's announcing, in the words of VP of Marketing Dan Vivoli, "a major software breakthrough for the graphics industry." The new software is called Cg, or C for graphics. This is all part of NVIDIA's plan to put reality out of business by rendering film quality details in real-time. While progress is being made, Dan still sees the convergence of the two art forms in terms of realism to be five to ten years away. Cg is NVIDIA's attempt to close the gap.

Dan describes Cg as "a high level graphics programming language which changes the paradigm for programming these real time graphics chips." The paradigm being changed of course is the current assembly mode process of writing code for graphics. In just a few lines Cg can accomplish more and more intuitively than many more times lines of assembly code.

The difference comes in the abstraction of the code to a specific GPU or API. Currently assembly language code is specific to distinct computer architecture. Cg's compiler performs all of this "heavy lifting" itself by abstracting the code and optimizing and tuning it to a particular GPU. And it does it all in a much simpler language. Admittedly, it's still fairly cryptic to the novice, but it's much more convenient for programmers.

This not only means that programmers can do more effects in the same amount of time; it also implies that programmers can attempt more difficult or realistic effects. "If you're really good at it," Dan explains, "then you can be even better at it because you're spending less time with the tedium of doing the assembly language programming and you get to spend more time doing the creative part with the higher level language."

And that's the point, as Dan points out. "Game developers don't want to be computer architects; they really want to be story-tellers and artists." But the providers of game technology have forced game makers to learn complicated codes in order to work with the tools. This is why Dan sees this as a completely natural step for NVIDIA. It even has a precedent in the evolution of NVIDIA's own driver technology. "It's about managing the architecture and the hardware," says Dan, which is "a natural thing for the hardware guy to do."

The software is compatible with almost anything. Since the Cg compiler supports the same language used by Direct X's compiler, compatibility won't be an issue. Moreover, the output to Direct X or OpenGL shaders makes Cg friendlier to other platforms like the Xbox, Mac or Linux.

Bleibt natürlich die Frage offen, was der Compiler wirklich erzeugt. Erzeugt er kompletten DirectX 8 / 9 Code oder lediglich Vertex und Pixel Shader Code. Ob Cg eine Alternative zu OpenGL 2.0 sein wird / sein soll, bleibt abzuwarten, da dort ebenfalls Vertex und Pixel Shader mittels C-artiger Sprache programmiert werden können. Ob andere Hersteller freien Zugang zu Cg haben werden bleibt ebenso offen, wäre aber für die Akzeptanz am Markt wünschenswert.

ATi's RV250

Hier ein paar Bilder von ATi's RV250.

ATi's R300

Hier ist ein gescannter Artikel einer Zeitschrift, in dem kurz auf die Leistung des R300 eingegangen wird. 15-20 % schneller unter 3D-Mark 2001 SE als eine NVIDIA GeForce 4 Ti 4600 - jedoch bei 1024x768, da limitiert die CPU wohl wesentlich mehr als die Grafikkarte, ausserdem sind die Treiber sicher noch in einem frühen Stadium.

John Carmack Interview bei Beyond3D

Beyond3D haben ein sehr interessantes Interview mit JC zur Doom III Technologie geführt.

ATi's R300 -> Radeon 10000 / RV250 -> Radeon 9000 ?

The Inquirer haben angeblich ATi's R300 basierende FireGL Karte auf der Computex 2002 gesichtet. Weiter wird in dem Artikel von der Radeon 10000 gesprochen, as eiegntlcih ATi's Namenskonventionen wiedersprechen würde, denn der Radeon 8xxx wurde wegen DirectX 8 so bezeichnet (Radeon 7xxx -> DirectX 7). Somit wäre Radeon 9000 (DirectX 9) logicher.

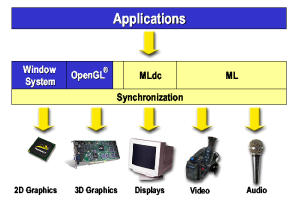

OpenML - mit breiter Herstellerunterstützung

Bei OpenML handelt es sich um den Versuch, eine plattformübergreifende Multimedia API (capturing, transporting, processing, displaying, and synchronizing digital media (2D and 3D graphics, audio and video processing, I/O, and networking), welche von folgenden Herstellern unterstützt wird:

- 3Dlabs Inc.

- ATI Technologies Inc.

- Discreet, a division of Autodesk, Inc.

- Evans & Sutherland Computer Corporation

- Intel Corporation

- NVIDIA Corporation Silicon Graphics, Inc.

- Sun Microsystems, Inc.

Professionelle OpenGL-Beschleuniger unter LightWave 7

Digit-Life haben verschiedene 3D-Beschleuniger unter der Verwendung von LightWave 7 getestet.

3D-Analyze 1.4 Beta

Ich habe die 1.4'er Beta online gestellt. Sie enthält einige neue Features, welche speziell Karten mit mangelnden DX8 Features (Pixel Shader, Cube Mapping, Bump Mapping, Environment Mapping) helfen könnte, DX8 Games und Anwendungen (z.B. 3D-Mark 2001 SE) doch zu bewältigen.

Talon Graphics

Talon Graphics ist ein Team aus 4 Leuten, welche angeblich eine neue Grafikkarte bauen wollen. Die Karte soll sich "Apocalypse" nennen und mittels SLI (welches von NVIDIA lizensiert werden muss) in 4 Versionen erscheinen soll. Ich halte das Projekt für kaum realisierbar, mit nur 4 Leuten. Das fängt beim Design an und geht mit den Treibern weiter, wenn man sich anschaut, wieviele Leute bei NVIDIA oder ATI an solchen "Details" arbeiten.

Here is what Ryan Warner has to say :

The Apocalypse line of graphics cards will be very impressive. We actually had to flip the card to where the processors are facing up. This is because of the size of the heatsink & fan combinations. We know graphics cards are not made like this because of heat problems between the card, and the CPU, but we are have a heatsink & fan design that will desperse the heat away from the CPU of most motherboards. The fan will actually be a dual fan (like on the Russian Tu-95 Bear Bomber). The clocks for the Apocalypse cards will be nearly double what the GeForce 4's are. With our new memory architecture you can see at the most 3 - 4 times the fill-rate of a GeForce 4.

The Anti-Aliasing for the Apocalypse 1500 will be at 16x (using the Selestec[tm], a new form of FSAA). Also, the Anisotropic Filtering is going to have the option of at least 128-tap. The blurring issue will not be a problem. Take 3DLabs 16x Anti-Aliasing on the Wildcat III for example, but without blurring.

Transform and Lighting will definetely be implemented in hardware, and so will Pixel and Vertex shaders.

3dfx T-Buffer is not dead. The one addition to the die is a space for a form of the 3dfx T-Buffer (TG-Buffer). Yes, we at Talon Graphics are fans of 3dfx. The first video card any of us ever owned was a 3dfx product.

Also on our list is surround-gaming features up to 5 monitors for a true surround-gaming experience.

As for the size of the card. The Apocalypse 1500 does have four processors. The length of the card will not be 30cm like the Voodoo 5 6000. The Apocalypse 1500 will be wide though. Our design for the card is different, and should not be any longer than a Voodoo 5 5500. The Apocalypse 1000 will be no longer than a GeForce 4. The Apocalypse 500 will be around the size of a Radeon 8500.

Here's some more specs:

Apocalypse 1500 - 4 chip SLI 512MB RAM (16x A-A)

Apocalypse 1000 - 2 chip SLI 256MB RAM (12x A-A)

Apocalypse 500 - 1 chip 128MB RAM (8x A-A)

Chip design is nearly complete, and board design is in full swing. I will be finishing the chip design this month (hopefully), and helping Josh finish the board design over the next 3 or 4 months. Than, it's on to silicon. Produce the drivers, and put the card into production. We're working hard on this project. I do want to stress that no other video card will be designed like this one, and look like this one.

We are hoping to have a design ready for production in one year, or less.

There's only one major issue that needs to be taken care of. That is getting the rights to use SLI from nVIDIA. Otherwise, we'll run into lawsuits, and so on. We want SLI because we believe that it is very effective, and our plan on how to use the technology will seriously increase the performance of the chipset. The SLI technique we're going to use can avoid buying a patent from nVIDIA. That is not going to be a problem either. Our implementation, we believe, will increase performance on older, current, and future programs.

The Talon Graphics Team :

Ryan Warner - Chip and Board Design (Founder)

Josh Anderson - Chip and Board Design (Co-Founder)

Seth Gilpin - Cooling Design

Shawn Middleton - Drivers

Open Source ATi Radeon 8500 3D Linux-Treiber

Wie in der DRI-Mailingliste zu lesen war, sponsort The Weather Channel die Entwicklung eines 3D Treibers für ATi's Radeon 8500. Momentan sind von ATi ja offiziell nur Linux-Treiber für die FirgeGL 8700 / 8800 Karten zu bekommen, welche jedoch auch auf der Radeon 8500 laufen. Der DRI-Teil wird von ATi's FireGL Team beigesteuert. Wann jedoch Pixel und Vertex Shader Extensions eingebaut werden ist momentan noch unklar. Erste Versionen der Treiber sollen im vierten Quartal verfügbar sein.

"The Weather Channel is funding TG to develop an open source 3D DRI

driver for the ATI Radeon 8500 graphics card. The driver will be

released to the XFree86 Project around Q4 of 2002, to be distributed to

the public in future versions of the XFree86 X Server."

> That is great news. I was about to inquire about those recently released

> FireGL drivers that are said to work with the 8500. Is the developement of

> those drivers related in any way to TG?

AFAIK, the drivers themselves utilize the DRI and were written by the FireGL group at ATI.

> As far as Doom3 Linux goes .. I think there's still a long way before Doom3

> can run with all features enabled on an open source ATI driver. As you are

> aware, Doom3 makes heavy use of pixel shaders and other advanced features.

> Don't ask about ETAs or what the plans for a 'technology test' of Doom3

> Linux are though, cause I have no idea .. all I can say is that Id would

> help out driver developement / testing / performance feedback on Linux as

> much as possible.

Correct, you won't see HW pixel shaders in this open source driver.

Perhaps someone can comment on HW pixel shader support in the FireGL binary only driver

ATi's RV250 und R300 Spezifikationen

3DCenter haben einen kurzen Artikel online, welcher sich mit den technischen Daten der beiden kommenden ATi GPU's beschäftigt.

Matrox Parhelia 512 - "Best Hardware of E3"

Hier gibts die Pressemitteilung.

NVIDIA beim 0,13µ Fertigungsprozess im Vorteil?

Laut diesem Artikel, wird NVIDIA vor der Konkurrenz ihren 0,13µ GPU vorstellen. Damit könnte sich andeuten, dass ATi's R300 anfangs in 0,15µ gefertigt wird. Dies wiederum hätte zur Folge, dass der R300 mit ca. 220 - 275 Mhz laufen würde, ähnlich wie Matrox Parhelia 512. Dies muss aber kein Nachteil sein. Ähnlich wie bei CPU's (Intel / AMD) kommt es auch bei GPU's auf die Leistung pro Mhz an, was gerade beim Pixel und Vertex Shader wichtig ist. Je komplexer diese Einheiten werden, umso schwieriger wird es, hier ein effizientes Design zu finden. Das Hauptproblem heutiger GPU's ist auch nicht der GPU-Takt, sondern vielmehr die vorhandene Speicherbandbreite. Die Vertex Shader haben bereits mehr als genug Datendurchsatz. Auch die Pixel Shader hängen momentan mehr von der Speicherbandbreite ab, als vom reinen Takt.

NVIDIA und anisotropische Filter Leistung

The Inquirer haben einen Artikel online, in dem NVIDIA zum Thema "schlechte Leistung beim anisotropischen Filtern" Stellung nimmt und Besserung verspricht.

"We got a nice explanation from nVidia here in Taipei, that Anisotropic performance in 28.32 and previous Geforce 4 drivers where not as fast as you might expect because the Nvidia driver team focused on FSAA performance first, since they accepted that as a priority. After that they started to work on improving Anisotrotropic performance, I'm told."

Neue PowerVR Demos und ein neuer Benchmark

PowerVR haben neue Demos und einen Stencil-Shadow Benchmark veröffentlicht, welcher gerade im Hinblick auf Doom III interessant sein dürfte.

Was bringt der neue OprnGL Treiber für ATi's Radeon 8500 ?

3DNow Galaxy haben ATi's neuen OpenGL Treiber getestet.

OT: Clawhammer Benchmarks

Hier die ersten Clawhammer Resultate, welche recht vielversprechend aussehen, von tecChannel:

Quake III Arena 1.17

Clawhammer 800 PC333 2.5-3-3 183 fps Athlon MP 800 PC333 2.5-3-3 130 fps Athlon MP 800 PC333 2.5-3-3 133 fps Athlon MP 800 PC333 2.0-2-2 135 fps Athlon MP 1667 PC333 2.5-3-3 210 fps Pentium 4 800 PC800-45 111 fps Pentium 4 1600 PC800-45 182 fps

OT: GTA3 Ruckelalarm?

Wiedereinmal verärgert ein übereifriger Kopierschutz (und/oder schlechte bzw. fehlende Tests auf unterschiedlichen Hardwarekonfigurationen) den Spielspaß. Laut dem Test in der aktuellen Gamestar soll ein No-CD Patch grobe Probleme beheben. Laut den Lizenzvereinbarungen darf man ein No-CD Patch nach 4 Wochen Frist einsetzen, wenn man Take 2 auf die Probleme aufmerksam gemacht hat. Take 2 arbeitet bereits an einem Patch. Im Gamestar Test wird die Radeon 8500 durchgehend als "nicht möglich, bzw. nicht speilbar" eingestuft. Da andere Spiele auf ATi's Radeon 8500 diese Probleme nicht haben, liegt der Fehler hier eindeutig bei Take 2.

NVIDIA's NV30 angeblich ca. 120 Mio. Transistoren

Laut einem Artikel im Wired Magazine soll NVIDIA's neue NV30 GPU aus ca. 120 Mio. Transitoren bestehenen.

NVIDIA-U Workshop

Vom 18. - 20. Juli 2002 wird in San Antonio (Texas) NVIDIA's "NVIDIA-U" Workshop stattfinden. Hier eine Übersicht der interessanten Themen:

- Volume Rendering

- Non-Photorealistic Rendering

- Shadows, Transparency and Visibility

- High Dynamic Range Rendering

- GPU-Accelerated Global Illumination

- Character Animation

- Non-Graphics Use Of GPUs

S3 SavageXP Review

VIAARENA haben ein Review des SavageXP veröffentlicht. Dort muss er gegen NVIDIA's GeForce2 MX 400 und ATi's Radeon VE(7000) antreten, welche er auch deutlich schlägt, wobei er allerdings auch über die doppelte Speicherbandbreite verfügt. Hier noch ein paar Daten des SavageXP, welcher von VIA auch als Zoetrope verkauft wird:

- Memory interface 64/128 bit DDR SDRAM

- Upto 64 MB external videomemory support, upto 32 MB embedded videomemory

- Core frequency upto 166 MHz, videomemory û upto 366 (183 DDR) MHz

- Two pixel pipelines with two TMUs each

- Possibility to integrate two pixel pipelines into one with four texture modules

- Support of bilinear and trilinear filtration

- S3TC/DXTC texture compression support

- Full screen anti-aliasing support with programmed filtering templates

- Edge anti-aliasing support

- T&L hardware unit

- RAMDAC frequency 350 MHz

- DVI support, embedded NTSC/PAL TV-encoder

- Two-monitor configurations support with any devices combinations

- Simultaneous scaling support and two videostreams output

- PowerWise power saving technology

- AGP 2x/4x support

- 166 Mhz GPU speed

3Dlabs P10 Technologie Preview

Beyond3D haben ein Preview von 3Dlabs P10 VPU veröffentlicht, welches recht detailiert zur Sache geht.

VIA und ATi wollen AGP 8x in den mainstream Markt drücken

VIA und ATi arbeiten zusammen, um den AGP 8x Standard auch im mainstream Markt anzusiedeln.

ATi's Radeon Karten zu langsam für GTA 3?

In diesem Forum wird die Leistung von GTA 3 unter verschiedenen Grafikkarten heftig diskutiert.

Unfortunately, in testing ATI cards performed choppy at best. My

recommendation is to keep both your desktop and game at 16 bit color depth.

I'm sorry for the inconvenience this may cause you, but I'm only being

honest. The processor in combination with the driver support for ATI cards

is a bit below the nvidia chipset as far as quality goes.

To be honest, in a strict hardware and driver comparison only, the lowest end GeForce card can run rings around almost any Radeon card. As far as assumptions go, you can assume whatever you want. As far as the truth goes, I'm just passing along information that I got in a .pdf format document because they were so secretive in the production that they wouldn't let us know anything else about it. To be honest, in a strict hardware and driver comparison, the lowest end GeForce card can run rings around almost any Radeon card.

ATi's R300 spielt Schlüsselrolle bei Intel's Enterprise Workstation Platform Demo

Hier gibts ATi's Pressemitteilung.

Computex 2002 - Teil 3

Hier die dritten Teile: Anandtech, HardOCP und TBREAK.COM

ATi's RV250 und R300

Nachdem Anandtech einen lauffähigen R300 bewundern durften, sind nun noch ein paar Infos zum RV250 aufgetaucht.

"The architecture is very similar to R200 (DX8 part) with a few things removed and core clock speeds are expected to be close to 300MHz according to our sources today. At 300MHz the RV250 has the potential of being tough competition for the GeForce4 Ti 4200, but we'll have to wait for its launch before we can decide for certain."

NVIDIA GeForce 4 - Drei Monate später

Hier gibt es ein interessantes Editorial zu NVIDIA's GeForce 4, welches auch die preisliche und leistungsmäßige Entwicklung der letzten drei Monate betrachtet.

NVIDIA's NV30

Ein kleines Preview zu NVIDIA's NV30 gibt es hier. Leider gibt es bisher keine Angaben bezüglich Displacement Mappings oder HOS. Allerdings sollte man vorsichtig sein und nicht alles blind glauben, deshalb hab ich es mal ein wenig kommentiert.

- NV30 aka "Omen" (Farewell GeForce, hello Demian)

- AGP 4x and 8x

- Copper Core GPU Processor 0.13 m default clock 450 MHz - NVIDIA hat sich schon oft bei hohen Mhz-Zahlen die Finger verbrannt

- 73 million transistors

- 8 pipelines

- 128 MB DDR-SDRAM @ 375 MHz x2 = 750Mhz and 256 bit ; yeah 256 bit!

- 370Mhz RAMDAC

- Direct X 9.X compatible

- Quad Vertex Shaders

- Dual Pixel Shaders - 8 Pipelines und nur 2 Shader ? Was machen die restlichen 6 Pipelines ? Shader und Pipelines lassen sich nicht richtig trennen, daher ist diese Angabe völliger Unsinn

- 85 bone capable - was soll das sein? Matrix skinning mit max. 85 "Knochen" ?

- Lightspeed Memory Architecture III

- Quad Cache memory caching subsystem

- Dual Z-buffers for greater compression without losses

- Visibility sub-system

- NvAuto advanced pre-charge

- Advanced Hardware Anisotropic Filtering - A new 12nvx mode that delivers improved subpixel coverage, texture placement and quality. -12nvx bezeichnet FSAA, dies hat nichts mit anisotropischen Filtern zu tun.

- 12nvx mode should deliver 80% better subpixel coverage and placement than previous modes

- Hardware bumpmapping - ist schon seit DirectX 6/7 möglich, zählt seit DirectX 8/9 auch zu den Möglichkeiten des Pixel Shaders

- 4 Textures/Pixel in a single clock cycle "loop back" can also apply an additional 4 textures per rendering pass

- A separate second copper processor running at 450Mhz an 0.13m as well - handle all T&L now called TT&L (True Time and Lighting) NVAutoShaper a new prechached and precacheable system

- Programmers can also add shapes to be temporarily stored in precache to speed things up

- Latest Open GL

- Backward Glide game capable thanks to NvBlur (Yeah, new Glide!) - Ich glaubs erst wenn ichs sehe, wer benötigt einen NV30 um alte Glide-Games zu spielen?

- NView Multi-display Technology

- Built in re-programmable DVD and TV decoder chip

Computex 2002 - Teil 2

Hier die zweiten Teile: Anandtech, HardOCP und TBREAK.COM

Interessant auch der Kommentar bei TBREAK.COM: "Our last stop for Day 2 was at nVidia. Yes, you read it right...unfortunately we cant tell ya what we saw there ;) Until tommorow then..."

SiS Xabre 400 Review

HEXUS.net haben ein Xabre 400 Review online. Die Leistung legt etwa auf dem Niveau einer NVIDIA GeForce 4 MX 440.

Matrox Parhelia 512 Bilder

Hier gehts zu den 4 Bildern der Parheila 512.

NVIDIA GeForce 4 GO 440 Review

Hot Hardware haben NVIDIA's mobile GeForce 4 Version getestet.

Computex 2002 - Teil 1

Hier drei gute Computex Berichte: Anandtech, HardOCP und TBREAK.COM

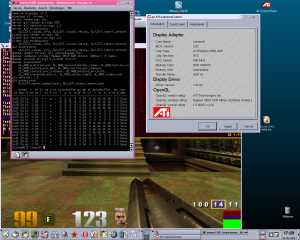

Linux und ATi's FireGL Treiber auf der Radeon 8500

Hier ein kleiner Screenshot.

Kostenlose 3D-Treiber für die Radeon 8500 unter Linux

ATi hat endlich die XFree86 4.1.0 / 4.2.0 3D-Treiber für Linux released. Offiziell werden nur die FireGL 8700 / 8800 unterstützt, jedoch laufen die Treiber auch auf der Radeon 8500.

I want to believe

Der RV250 soll angeblich mit Radeon 9000 bezeichnet werden...

S3 bietet SavageXP in Lizenz (Certified Partner Program)

Der SavageXP wird als preiswerter mainstream GPU eingesetzt werden, welcher das untere Leistungssegment bedient.

Trident's XP4 mit vollem DirectX 8.1 und DirectX 9 Support

Tridents neuer XP4 sieht recht vielversprechend aus. DirectX 8.1 und 9 Support bei gerade mal 30 Mio. Transistoren klingt nicht schlecht.

ATi Radeon 8500 AIW Review

Beyond3D haben ein gutes ATi Radeon 8500 AIW Review online.

Siggraph 2002

Hier ein paar interessante Themen (Courses) der Siggraph 2002, natürlich gibt es noch vieles mehr.

- Advanced Issues in Level of Detail

- State of the Art in Hardware Shading

- Practical Parallel Rendering

- Recent Advances in Non-Photorealistic Rendering for Art and Visualization

- Interactive Geometric Computations Using Graphics Hardware

- Real-Time Shading Languages

- Performance OpenGL: Platform-Independent Techniques

- High-Quality Volume Graphics on Consumer PC Hardware

- A Practical Guide to Global Illumination Using Photon Mapping

- Image Processing for Volume Graphics

- Intellectual Property, Copyright, and Digital Rights Management for Computer Graphics

- Graphics Hardware

- 3D Acquisition and Image Based Rendering

- Shadows, Translucency, and Visibility

- Painting and Non-Photorealistic Graphics

Kommentare von John Carmack

Auf Slashdot gibt es einen langen Thread zum Thema Doom III (GeForce 4 schneller als Radeon 8500, Doom III nur in mittlerer Qualität gezeigt, Doom III und Linux .... ) - dazu hat sich dann auch mal John Carmack geäußert:

Misrepresented:

This batch of comments from me have let people draw conclusions that leave me scratching me head wondering how they managed to get from what I said to what they heard.

Other people have outlined the issues in detail in comments already, but the crux is that, even with driver quality removed from the discussion (not counting conformance issues, running at fill limited resolutions), GF4 hardware is still faster than 8500 hardware on basically everything I tested. The 8500 SHOULD have been faster on paper, but isn't in real life.

The hardware we used at E3 was not an 8500, and while the drivers were still a bit raw, the performance was very good indeed.

Take with a grain of salt any comment from me that has been paraphrased, but if it is an actual in-context quote from email, I try very hard to be precise in my statements. Read carefully.

John Carmack

High end hardware reasoning:

We know for sure that we will be excluding some of the game buying public with fairly stiff hardware requirements, but we still think it is the right thing to do.

The requirement for GF1/Radeon 7500 as an absolute minimum is fundamental to the way the technology works, and was non-negotiable for the advances that I wanted to make. At the very beginning of development, I worked a bit on elaborate schemes to try and get some level of compatibility with Voodoo / TNT / Rage128 class hardware, but it would have looked like crap, and I decided it wasn't worth it.

The comfortable minimum performance level on this class of hardware is determined by what the artists and level designers produce. It would be possible to carefully craft a DOOM engine game that ran at good speed on an original SDR GF1, but it would cramp the artistic freedom of the designers a lot as they worried more about performance than aesthetics and gameplay.

Our "full impact" platform from the beginning has been targeted at GF3/Xbox level hardware. Slower hardware can disable features, and faster hardware gets higher frame rates and rendering quality. Even at this target, designers need to be more cognizant of performance than they were with Q3, and we expect some licensee to take an even more aggressive performance stance for games shipping in following years.

Games using the new engine will be on shelves FIVEYEARS (or more) after the initial design decisions were made. We had a couple licensees make two generations of products with the Q3 engine, and we expect that to hold true for DOOM as well. The hardware-only decision for Q3 was controversial at the time, but I feel it clearly turned out to be correct. I am confident the target for DOOM will also be seen as correct once there is a little perspective on it.

Unrelated linux note: yes, there will almost certainly be a linux binary for the game. It will probably only work on the nvidia drivers initially, but I will assist any project attempting to get the necessary driver support on on other cards.

John Carmack

1Gbit/s (1GHz) DDR-II im nächsten Frühjahr

Samsung wird diesen DDR-II Grafikspeicher im nächsten Frühjahr in großen Stückzahlen produzieren.

STMicro Interview

Pasquale Pistorio, CEO von STMicro habe bei ebnews ein Interview gegeben.

Open Source GPU

Hier kann man sich über einen Open Source GPU informieren.